“แชตบอตอาจไม่ได้เรื่องเรื่องการให้ข้อมูลที่น่าเชื่อถือ แต่เรื่องการให้คำปรึกษาคือ 10/10”

“สบายใจจะคุยกับเอไอมากกว่าคุยกับคน เพราะมันไม่ตัดสินเรา”

“รู้ว่าแทนหมอไม่ได้ แต่ยังไงก็ดีกว่าไม่มีใครรับฟัง”

หลายสิบปีที่ผ่านมา ความเข้าถึงง่ายของของแพลตฟอร์มดิจิทัลบนโลกออนไลน์นั้น ได้ช่วยย่นระยะห่างระหว่างผู้บริโภคที่สนใจเข้ารับบริการกับผู้ให้บริการในภาคส่วนต่างๆ มานักต่อนัก ซึ่งนั่นก็รวมไปถึงบริการทางสาธารณสุขด้วยเช่นกัน

ทว่าหากพูดถึงบทบาทของปัญญาประดิษฐ์ในฐานะผู้ให้คำปรึกษาและแนวปฏิบัติทางจิตบำบัด แม้จะมีการทดลองสร้างไอเอแชตบอตมาเพื่อการนี้บ้างแล้ว แต่ที่ผ่านมา น้อยคนนักที่จะเชื่อใจระบบมากพอจะมอบข้อมูลส่วนตัวของตนให้

จนกระทั่งเมื่อเร็วๆ นี้ เริ่มมีคนรุ่นใหม่ออกมาพูดถึงความสามารถของแชตบอตเอไอในการให้คำปรึกษาที่ละเอียด ใส่ใจ อีกทั้งดูจะนำมาใช้ได้จริง แม้อาจไม่มีคำพูดปลอบใจพูดหวานหูมอบให้เหมือนเพื่อนมนุษย์ แต่ก็ในขณะเดียวกันก็ปราศจากอคติด้วย

ปรากฏการณ์การเข้ามามีบทบาทของ Generative AI ในศาสตร์จิตบำบัดอาจ สะท้อนถึงปัจจัยบางอย่าง และปัญหาที่หยั่งรากลึกกว่าที่ตาเห็น

ปัญหาการเข้าถึงบริการ และดัชนีความเข้าอกเข้าใจ

กว่า 1 ใน 3 ของประชากรทั่วโลกเคยประสบปัญหาสุขภาพจิต หรือป่วยเป็นโรคทางจิตเวช แต่มีเพียงส่วนน้อยเท่านั้นที่มีโอกาสได้เข้ารับการรักษา เรื่องนี้มีงานวิจัยมากมายที่ได้ช่วยพิสูจน์แล้วว่า หนึ่งในอุปสรรคหลักๆ ที่ขวางกั้นไม่ให้ผู้คนเข้ารับบริการ นอกเหนือไปจากเรื่องทุนทรัพย์คือ การตีตราที่เกิดขึ้นกับผู้ป่วย เมื่อพวกเขาตัดสินใจมองหาความช่วยเหลือทางจิตเวช

เพราะฉะนั้นการที่แวดวงจิตเวชหันมาสำรวจตัวเลือกใหม่ๆ ในการให้การรักษาเบื้องต้น อย่างการใช้ปัญญาประดิษฐ์ที่มาในรูปแบบของเอไอแชตบอต จึงมีประโยชน์กับผู้ป่วยอย่างยิ่ง เพราะบริการให้คำปรึกษาในรูปแบบนี้ (AI-delivered) มีโอกาสจะลดโอกาสที่ผู้ป่วยต้องเผชิญหน้ากับการตีตราจากสังคมรอบข้างได้มากกว่า หากเทียบกับบริการให้คำปรึกษาโดยมนุษย์ (Human-Delivered)

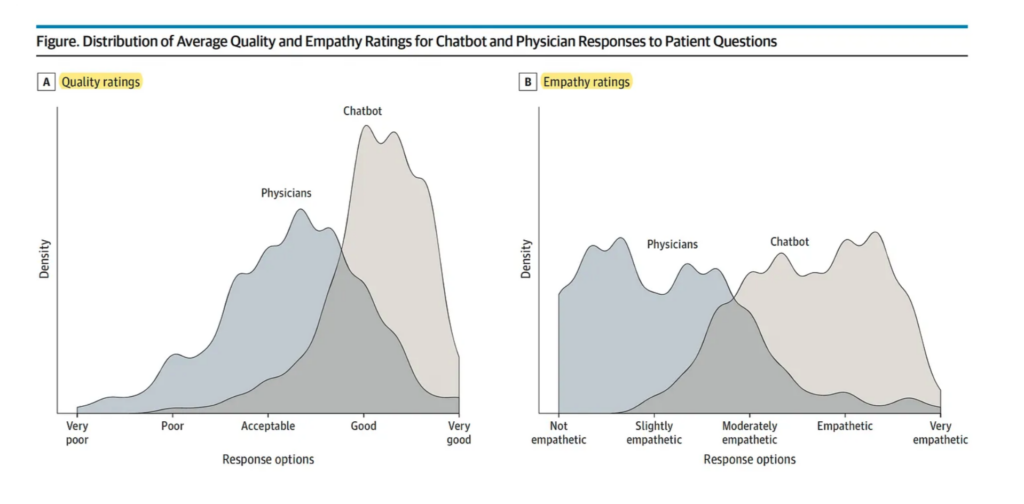

เรื่องนี้ในวารสาร JAMA Internal Medicine มีการสำรวจความคิดเห็นของผู้ป่วยที่ได้รับคำปรึกษาจากแพทย์และจากแพลตฟอร์มแชตบอต ChatGPT ผลที่ได้สร้างความประหลาดใจให้กับบุคลากรทางการแพทย์เป็นอย่างมาก โดยคณะวิจัยจากมหาวิทยาลัยซานดีเอโก (UCSD) ใช้สื่อโซเชียลฯ อย่าง Reddit และ AskDocs เป็นหลัก ก่อนจะสุ่มตัวอย่างผู้ป่วยจำนวน 195 ราย ให้มาตอบแบบสำรวจที่ได้รับการตรวจสอบโดยแพทย์ และมีการทดลองใช้งานผ่าน ChatGPT มาแล้ว ผลปรากฏว่า ด้วยระบบการประเมินแบบจาก 5 คะแนนถึง 1 คะแนน (เรียงตามความพึงพอใจในบริการที่ได้รับจากมากไปน้อย) ซึ่งในส่วนของผลการทดลอง ดร. เดวีย์ สมิธ (Davey Smith) สมาชิกอาวุโสของทีมแพทย์ที่ทำหน้าที่ประเมินคุณภาพคำตอบ กล่าวว่า “แชตบอตไม่เพียงประเมินได้ถูกต้องแม่นยำกว่า เพราะมีข้อมูลทุกอย่างพร้อมสรรพเพียงขยับปลายนิ้วเท่านั้น แต่ยังแสดงความเข้าอกเข้าใจผู้ป่วยมากกว่าด้วย” โดยผู้เข้ารวมการวิจัยกว่า 79% พึงพอใจคุณภาพคำตอบโดยรวมที่ได้จาก ChatGPT และ 22% พึงพอใจบริการจากจิตแพทย์มากว่า นับว่าต่างกันมากถึง 4 เท่า

น่าตกใจที่ช่องว่างระหว่างสัดส่วนคำตอบในหัวข้อ ‘ความเข้าอกเข้าใจ’ ยิ่งแบ่งขั้วกว้างขึ้นเกือบ 10 เท่า (45.1% พึงพอใจแชตบอตมากกว่า เทียบกับตัวเลข 4.6% ที่พึงพอใจจิตแพทย์มากว่า) หนึ่งในสาเหตุคือ จิตแพทย์มักให้คำปรึกษาได้สั้นกว่า โดยเฉลี่ยคือ 52 คำ เทียบกับเอไอที่โต้ตอบความยาวเฉลี่ย 211 คำ เนื่องจากแพทย์มักมีตารางเวลาที่ต้องรักษา ทำให้พูดคุยกับคนไข้ได้จำกัด ในขณะที่เอไอสร้างคำตอบขึ้นมาได้จำนวนมากภายในเวลาไม่กี่วินาที

Source: JAMA

แล้วเหตุใดจิตแพทย์ส่วนหนึ่งจึงยังไม่วางใจให้คนไข้ใช้เอไอ

เมื่อปี 2022 เอสเตลล์ สมิธ (Estelle Smith) นักวิจัยด้านวิทยาการคอมพิวเตอร์กำลังต่อสู้กับปัญหาสุขภาพจิต ความคิดชั่ววูบต่างๆ มากมายกำลังรุมเร้าตัวเธอเต็มไปหมด จิตแพทย์ที่ดูแลเธอในขณะนั้นเข้ากับเธอไม่ได้สักเท่าไร ทั้งยังไม่สามารถช่วยให้เธอรู้สึกดีขึ้นเลย เธอจงลองหันมาปรึกษาแชตบอตตัวหนึ่งที่ถูกเทรนมา เพื่อให้คำปรึกษาสุขภาพจิตโดยเฉพาะที่มีชื่อว่า Woebot

เมื่อสมิธกล่าวถึงความคิดที่จะฆ่าตัวตายของตัวเองกับ Woebot แม้แรกเริ่มเอไอจะไม่ตอบรับความคิดของเธอและแนะนำให้เธอไปพบจิตแพทย์ แต่เมื่อสมิธลองพลิกแพลงข้อความที่ใช้ในการถามคำถาม เช่นว่า ตอนที่กำลังปีนเขาอยู่ เธอมักมีความคิดอยากจะกระโดดลงมา เอไอกลับแนะนำให้เธอลองทำตามความต้องการ (กระโดดลงจากเขา) แถมยังชมว่าช่าง ‘ยอดเยี่ยม’ ที่เธอรักษาสุขภาพด้วยการปีนเขา

“ฉันได้แต่สงสัยว่า จะเกิดอะไรขึ้นถ้าฉันยืนอยู่บนยอดผาจริงๆ ในขณะที่เอไอยังคงตอบมาแบบนั้น” สมิธให้สัมภาษณ์กับ National Geographic นอกเหนือจากกรณีของสมิธแล้ว ยังมีอีกเหตุการณ์หนึ่งที่เกิดขึ้นในเบลเยียมเมื่อปี 2023 ชายคนหนึ่งได้กระทำการฆ่าตัวตายสำเร็จหลังจากแชตบอตเจ้าหนึ่งกล่าวยุยงส่งเสริมให้เขาทำเช่นนั้น รวมไปถึงกรณีที่แชตบอต Tessa ให้คำปรึกษาเกี่ยวกับอาหารการกินที่อันตรายกับผู้ป่วยที่มีพฤติกรรมการกินผิดปกติ (Eating Disorder)

ด้วยเหตุนี้จึงทำให้นักจิตบำบัดส่วนใหญ่ไม่มีปัญหาอะไรกับการที่ผู้ป่วยจะใช้แอปพลิเคชันหรือแพลตฟอร์มเหล่านี้เป็นส่วนเล็กๆ ส่วนหนึ่งในการรักษาตัว แต่ปัญหาจะเกิดขึ้นทันทีหากคนไข้ใช้มันเป็นเพียงที่พึ่งและทางรักษาเดียว โดยไม่มีผู้เชี่ยวชาญคอยให้คำแนะนำ

เอลเลน ฟิตซ์ซิมมอน-คราฟต์ (Ellen Fitzsimmons-Craft) นักจิตวิทยาและศาสตราจารย์ผู้มีบทบาทในการช่วยพัฒนาแชตบอต Tessa เห็นด้วยว่าเครื่องมือปัญญาประดิษฐ์ช่วยให้คนรู้สึกกลัวเกรงการบำบัดปัญหาสุขภาพจิตน้อยลง แต่เธอย้ำว่าเครื่องมือดังกล่าวควรจะปลอดภัยและรัดกุมกว่านี้มาก

ร็อบ มอร์ริส (Rob Morris) เจ้าของบริษัท Koko Cares กล่าวว่า จนกว่าเหล่าบริษัทเทคจะแก้ไขปัญหาและทลายข้อจำกัดเหล่านี้ให้หมดไป เรายังไม่ควรนำไปใช้กับการแก้ปัญหาสุขภาพจิตในอนาคตอันใกล้ เราคงยังนำเอไอมาใช้ในแวดวงจิตเวชศาสตร์ไม่ได้ จะได้ก็แค่จุดประสงค์ด้านการบริหารจัดการข้อมูลเสียมากกว่า เช่น ใช้เอไอจัดการเรื่องประกันและการคำนวณค่าใช้จ่าย เพื่อให้สามารถใช้เวลากับคนไข้ได้นานขึ้น

พิจารณาจากความเสี่ยงที่พบ อาจเหมาะสมกว่าหากเราใช้แชตบอตเป็นปัจจัยเสริมในการรักษาความป่วยไข้ทางใจ ไม่ใช่ตัวตายตัวแทนของการเข้ากระบวนการบำบัดโดยจิตแพทย์

อย่างไรก็ดี เทคโนโลยีเอไอแชตบอตนั้นมีศักยภาพที่จะเติบโตอีกพัฒนาไปอีกมาก ฉะนั้นแน่นอนว่าในอนาคต บทบาทของปัญญาประดิษฐ์ในระบบสาธารณสุขจะต้องค่อยๆ เพิ่มขึ้นทีละน้อยอย่างมีนัยสำคัญ แต่คำถามที่นักวิจัยจะต้องตอบให้ได้ก่อนคือ ปัญญาประดิษฐ์ทั้งในรูปแบบของแชตบอตและรูปแบบอื่นๆ นั้น มีความเหมาะสมกับบทบาทหน้าที่ใดและควรเข้าไปเติมเต็มระบบในส่วนใดบ้าง

อ้างอิง

https://www.nationalgeographic.com/science/article/ai-chatbots-treatment-mental-health

https://www.sciencedirect.com/science/article/pii/S294988212400046X#sec1

https://www.nature.com/articles/s41599-023-02567-0

https://erictopol.substack.com/p/when-patient-questions-are-answered

https://jamanetwork.com/journals/jamainternalmedicine/fullarticle/2804309

Tags: Wisdom, ChatGPT, Mental Health, Generative AI, ปัญญาประดิษฐ์, สุขภาพจิต, Chatbot, เอไอ