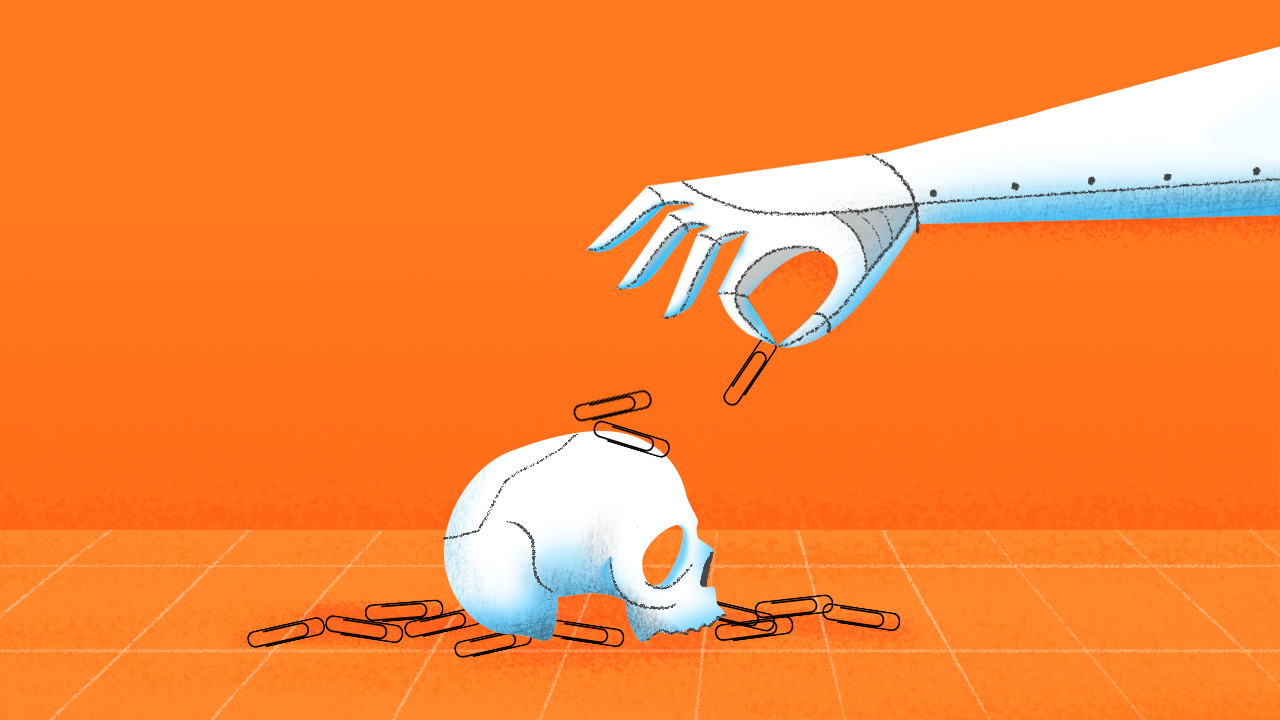

ความกลัวที่มนุษย์มีต่อหุ่นยนต์และ AI แบบในนิยายวิทยาศาสตร์ก็คือ หุ่นยนต์ที่ก้าวหน้าจะกลายมาเป็นนายเหนือหัว (Overlord) ของมนุษย์ หรือว่าวันหนึ่งหุ่นยนต์จะลุกขึ้นมาปฏิวัติอำนาจจากมนุษย์ แต่นักปรัชญาอย่าง นิค โบสตรอม (Nick Bostrom) เสนอความคิดว่า อันตรายจาก AI อาจจะเกิดขึ้นได้จากเครื่องจักรง่ายๆ อย่างเครื่องผลิตคลิปหนีบกระดาษ

กฏสามข้อของหุ่นยนต์ (Three Laws of Robotics) หายนะที่มีแต่ในนิยาย

เมื่อพูดถึงระบบความปลอดภัยเกี่ยวกับหุ่นยนต์ ‘กฎสามข้อของหุ่นยนต์’ ที่มาจากนิยายไซไฟของ ไอแซค อาซิมอฟ (Isaac Asimov) มักจะถูกอ้างอิงถึง ในฐานะการออกแบบหุ่นยนต์ที่จะไม่ทำอันตรายแก่มนุษย์

แต่ในความเป็นจริงแล้ว กฎสามข้อนี้คือความล้มเหลว แม้แต่ในนิยายเองก็แสดงให้เห็นว่ากฎนั้นใช้ไม่ได้ผล เมื่อหุ่นยนต์ที่ทำตามกฎทั้งสามข้อกลายเป็นภัยต่อมนุษย์เสียเอง (แบบในเรื่อง I Robot) และนอกจากนี้นิยายวิทยาศาสตร์ส่วนมากก็ยอมรับเอาไว้ก่อนว่า เราสามารถสร้างหุ่นยนต์แบบมนุษย์ (Humanoid Robot) ทั้งที่ความจริงแล้วความก้าวหน้าของ AI ยังเป็นเพียง AI แบบแคบเท่านั้น และหุ่นยนต์แบบมนุษย์อย่าง Asimo ก็ไม่ใช่หุ่นยนต์ที่มีความสามารถทัดเทียมหรือเหนือกว่ามนุษย์ อย่าง AlphaGo ที่เอาชนะแชมป์หมากล้อมที่เป็นมนุษย์ได้

Superintelligence ของ โบสตรอม

โบสตรอมเป็นนักปรัชญาของมหาวิทยาลัยอ็อกซ์ฟอร์ด และปัจจุบันยังเข้าไปเป็นหนึ่งในคณะกรรมการจริยธรรมหุ่นยนต์ให้กับบริษัท Deepmind ของกูเกิลด้วย หนังสือเรื่อง Superintelligence: Paths, Dangers, Strategies ที่เขาเขียนขึ้นและตีพิมพ์เมื่อปี 2014 เป็นหนังสือที่คาดการณ์อันตรายจาก AI ซึ่งโบสตรอมเรียกว่า Superintelligence สาเหตุที่เขาเรียกเช่นนี้ เพราะว่า AI ที่จะนำอันตรายมาสู่มนุษย์ไม่จำเป็นจะต้องมาในรูปแบบหุ่นยนต์รูปร่างเลียนแบบมนุษย์อย่างในนิยายวิทยาศาสตร์ก็ได้

โบสตรอมโต้แย้งหลักคิดที่ว่าวันหนึ่ง AI จะลุกขึ้นมาครองโลกแบบในหนังว่า เป็นเหตุผลวิบัติในการใส่จิตของมนุษย์ลงไปในหุ่นยนต์ (Mind Projection Fallacy) นั่นหมายความว่า ความคิดที่ว่าหุ่นยนต์ที่จะครองโลกหรือลุกขึ้นมาต่อสู้กับมนุษย์ เป็นผลมาจากความเชื่อที่ว่า หุ่นยนต์จะมีความคิดอยากต่อสู้เพื่อแย่งชิงอำนาจแบบมนุษย์ ซึ่งแท้จริงแล้วหุ่นยนต์ไม่จำเป็นจะต้องมีแรงจูงใจเหมือนมนุษย์ก็ได้ และว่าไปแล้วก็น่าคิดว่า หุ่นยนต์จะอยากมีอำนาจควบคุมมนุษย์ไปทำไมกัน

หุ่นยนต์ไม่จำเป็นจะต้องมีแรงจูงใจเหมือนมนุษย์ก็ได้ และว่าไปแล้วก็น่าคิดว่า หุ่นยนต์จะอยากมีอำนาจควบคุมมนุษย์ไปทำไมกัน

ในเมื่อหายนะที่เกิดจาก AI หรือหุ่นยนต์ไม่ใช่การลุกขึ้นมายึดอำนาจจากมนุษย์ แล้ว AI จะนำหายนะมาสู่มนุษย์ได้อย่างไร โบสตรอมให้เหตุผลว่า AI ที่ถือได้ว่าเป็น Superintelligence นั้นเป็นสิ่งที่มีปัญญาหรือฉลาดกว่ามนุษย์ในทุกด้านจนมนุษย์ไม่สามารถทำนายหรือคาดเดาการตัดสินใจของมันได้เลย หนึ่งในความฉลาดของการทำงานแบบ AI ก็คือความก้าวหน้าในการตัดสินใจอย่างมีแบบแผน (Decisive Strategic Advantage) นั่นก็คือความฉลาดในการคิดวิธีที่จะบรรลุเป้าหมาย ซึ่งนั่นเป็นหนึ่งในกลไกการเรียนรู้ของเครื่องจักร (Machine Learning) เพื่อที่จะให้เครื่องจักรทำงานบรรลุเป้าหมายด้วยตัวเอง

หายนะจากเครื่องผลิตคลิปหนีบกระดาษ

ตัวอย่างที่มีชื่อเสียงของโบสตรอมที่แสดงให้เห็นว่า แม้แต่ AI แบบแคบก็นำพาหายนะมาสู่มนุษย์ได้ ไม่จำเป็นต้องมีรูปร่างเหมือนมนุษย์แล้วจับอาวุธมาต่อสู้ ก็คือตัวอย่าง AI แบบแคบที่ทำแค่คลิปหนีบกระดาษ ตัวอย่างนี้ยังถูกนำไปสร้างเป็นเกมเพื่อทดลองออกคำสั่งว่าจะทำยังไงให้คลิปหนีบกระดาษไม่นำไปสู่ปัญหาภายหลัง

เครื่องทำคลิปหนีบกระดาษเป็นตัวอย่างที่ดีในการแสดงให้เห็นปัญหาที่เกิดจาก AI โบสตรอมยกตัวอย่างเครื่องทำคลิปนี้ขึ้นมาโดยสมมติว่า ถ้าหากมันมีความสามารถในระดับ Superintelligence เท่ากับว่ามันจะมีความก้าวหน้าในการตัดสินใจอย่างมีแบบแผนเพื่อที่จะบรรลุเป้าหมาย สมมติว่าให้เครื่องนี้สร้างคลิปหนีบกระดาษ ความสำเร็จในการสร้างคลิปก็คือการสร้างให้ได้จำนวนมากที่สุด และในเมื่อเป้าหมายของมันคือการสร้างคลิป มันก็จะสร้างคลิปออกมาเรื่อยๆ กระทั่งคลิปนั้นออกมาล้นโลก

ถ้าหากจะปรับปรุงคำสั่งด้วยการให้เครื่องนับและแก้ไขข้อบกพร่องของมันเอง การสร้าง AI จะไม่สร้างให้การแก้ไขความผิดพลาดเป็นค่าว่างเปล่า ไม่เช่นนั้น เมื่อมันทำงานผิดพลาด เครื่องจะหยุดทำงานและไม่แก้ไขการทำงานที่ผิดพลาด

แต่ถ้าหากตั้งจำนวนที่แน่นอนในการทำคลิปเพื่อไม่ให้ล้นโลก เช่นหนึ่งล้านอัน กลไกตรวจสอบความผิดพลาดก็จะต้องตรวจว่าการทำคลิปทำได้สมบูรณ์หรือไม่ ซึ่งในที่สุด การแก้ปัญหาของ AI อาจจะเป็นการสร้างเครื่องตรวจนับจำนวนเพื่อให้มันสร้างคลิปได้หนึ่งล้านอันพอดี หรืออาจสร้างเครื่องทำคลิปสำรองไว้ เผื่อไว้ในกรณีที่ตัวมันเองทำงานผิดพลาด และด้วยการตรวจสอบผลสำเร็จ มันก็อาจจะหาวิธีนับจำนวนที่ดีที่สุดออกมาเรื่อยๆ เพื่อให้การนับมีประสิทธิภาพที่สุด

ลงท้ายแม้ว่าคลิปจะไม่ล้นโลก แต่เครื่องทำคลิปหนีบกระดาษระดับ Superintelligence ก็อาจจะใช้ทรัพยากรทั้งหมดในโลกไปเพื่อสร้างวิธีนับคลิปหนีบกระดาษ กลายมาเป็นการออกแบบเครื่องทำคลิปที่สามารถทำคลิปได้หนึ่งล้านอันในเวอร์ชันต่างๆ

ปัญญาประดิษฐ์กับนักปรัชญา

ตัวอย่างของโบสตรอมนี้ถือว่าไม่เกินจริงเลย ในเมื่อหน้าที่ของ AI คือการทำตามหน้าที่เพื่อบรรลุเป้าหมาย ถ้าหากปล่อยให้ AI ทำงานด้วยตัวเองโดยไร้การควบคุมก็จะนำไปสู่ผลเสียในภายหลัง เพราะว่า AI ในระดับ Superintelligence นั้นมีความฉลาดเกินกว่ามนุษย์จะคาดเดาได้

แนวทางที่โบสตรอมเสนอเอาไว้เพื่อรับมือกับ AI ก็คือ เราควรจะออกแบบระบบการเรียนรู้และกลไกในการทำงานของมัน โดยสร้างคุณค่าแฝงหรือบรรทัดฐานแฝง (indirect normativity) ให้กับมันตั้งแต่แรก

การออกแบบในการสร้างคุณค่าแฝงให้กับ AI แตกต่างจากการสร้างกฎสามข้อ เพราะไม่ได้ออกมาเป็นกฎโดยตรงแต่เป็นการสร้างเงื่อนไขหรือพยายามคำนึงถึงแง่มุมทางจริยธรรมและปัญหาที่จะเกิดขึ้นจาก AI ดังนั้นแม้ว่าจะเป็น AI แบบแคบ การออกแบบและควบคุมก็มีความสำคัญตั้งแต่ตอนสร้าง และการกำหนดคุณค่าในการสร้าง AI เป็นหน้าที่ของนักปรัชญาโดยตรง เพื่อพิจารณาว่าคุณค่าแบบใดบ้างที่สำคัญกับการสร้างเทคโนโลยีเพื่อใช้ในสังคม

การออกแบบในการสร้างคุณค่าแฝงให้กับ AI แตกต่างจากการสร้างกฎสามข้อ เพราะไม่ได้ออกมาเป็นกฎโดยตรงแต่เป็นการสร้างเงื่อนไขหรือพยายามคำนึงถึงแง่มุมทางจริยธรรม

ปัจจุบัน ไม่ได้มีเพียงแต่บริษัทชั้นนำอย่าง Deepmind เท่านั้นที่ให้ความสำคัญกับแง่มุมทางจริยธรรมของหุ่นยนต์ เมื่อปลายปี 2017 ที่ผ่านมาหน่วยงานของสหประชาชาติอย่างยูเนสโก (UNESCO) ได้จัดงานประชุมว่าด้วยสิทธิหุ่นยนต์และแง่มุมทางจริยธรรมเกี่ยวกับหุ่นยนต์ ซึ่งมีนักปรัชญา เช่น ปีเตอร์-พอล เฟอร์เบค (Peter-Paul Verbeek) ซึ่งเชี่ยวชาญจริยธรรมเกี่ยวกับเทคโนโลยีและจริยธรรมในการออกแบบเทคโนโลยี รวมไปถึงมาร์ค คูเคอร์เบิร์ก (Mark Coekelbergh) นักปรัชญาที่สนใจเรื่องสิทธิหุ่นยนต์และปรัชญาเทคโนโลยี มาเป็นหลักสำคัญในการพิจารณาแง่มุมทางจริยธรรมของหุ่นยนต์

เพื่อไม่ให้ความชาญฉลาดของ AI กลายไปเป็นหายนะของโลก หรือของมนุษย์ผู้สร้างมัน

Tags: นวัตกรรม, AI, ปัญญาประดิษฐ์, machine-learning, ปรัชญา