หากเป็นแต่ก่อน งานวิจัยเกี่ยวกับการรักษาโรคคงจำกัดอยู่ในคณะแพทย์ของสถาบันวิชาการต่างๆ แต่ด้วยความฉลาดของเทคโนโลยีที่ได้รับการพัฒนาขึ้นอย่างต่อเนื่อง จึงทำให้เราเริ่มได้ยินข่าวดีเกี่ยวกับการวิจัยรักษาที่ทันสมัยขึ้น และข่าวดีล่าสุด เป็นข่าวดีที่มาจากแวดวงนักพัฒนาซอฟต์แวร์ ที่ใช้ปัญญาประดิษฐ์ หรือ AI ช่วยตรวจจับโรคมะเร็ง

อย่างที่เรารู้กัน มะเร็งคือการเติบโตของเซลล์ที่ผิดปกติ หรือที่เรียกกันว่าเนื้อร้าย มะเร็งหลายชนิดหากรู้เร็วก็จะสามารถรักษาได้ทันก่อนที่เชื้อร้ายจะแพร่กระจายไปสู่ส่วนอื่นๆ ของร่างกาย คนรักสุขภาพก็มักตรวจร่างกายอย่างสม่ำเสมอ แต่ก็ไม่ใช่ทุกครั้งที่ผลการตรวจจะสามารถบ่งชี้ได้อย่างแม่นยำว่าร่างกายของเรามีสิ่งผิดปกติที่กำลังเติบโต

ในงาน ‘Solve….with AI’ (แก้ปัญหา ด้วย AI) จัดโดยกูเกิล (Google) เมื่อต้นเดือนกรกฎาคมที่ผ่านมา รวมนักพัฒนาซอฟต์แวร์ให้มาเล่าโปรเจ็กต์สำคัญที่กำลังทำเพื่อสังคม ภายใต้โครงการ AI for Social Good หนึ่งในงานที่โดดเด่นก็คือ งานของลิลลี่ เพ็ง (Lily Peng) แพทย์หญิงผู้ซึ่งเบนเข็มนำความรู้ทางการแพทย์มาผนวกกับการพัฒนาซอฟต์แวร์ให้ชาญฉลาดยิ่งขึ้น เป็นแพทย์และนักพัฒนาที่นำ AI มาใช้กับวงการสุขภาพ โดยงานชิ้นล่าสุด ก็คือการสอนให้เครื่องจักรตรวจวิเคราะห์ภาพซีทีสแกนของปอด

การใช้ AI มาช่วยตรวจจับมะเร็งปอด ช่วยเพิ่มโอกาสให้เห็นเซลล์มะเร็งได้แม่นยำขึ้นกว่าเดิม โดยลดความผิดพลาดไปได้ 5-11% โครงการนี้ก็ทำความร่วมมือกับโรงพยาบาลในประเทศไทยและในอินเดียด้วย

ลิลลี เพ็ง แพทย์หญิง นักพัฒนาของกูเกิล

มะเร็งปอดเป็นมะเร็งประเภทที่ทำให้คนตายมากที่สุด แต่ก็เป็นมะเร็งประเภทที่หากเจอเร็วก็มีโอกาสรักษาให้หายได้เร็ว วิธีที่ผ่านมา หมอจะใช้วิธีการทำซีทีสแกนแล้ววินิจฉัยจากภาพสแกนนั้น ขั้นตอนการวินิจฉัยภาพเป็นขั้นตอนสำคัญและซับซ้อนมาก แพทย์ที่เชี่ยวชาญต้องอาศัยการฝึกฝนและประสบการณ์นานปี ที่จะวิเคราะห์ภาพซีทีสแกนแล้วมองได้ว่ามีก้อนเนื้อผิดปกติหรือไม่

ลิลลี เพ็ง เล่าว่าที่ AI เข้ามาช่วยงานหมอในช่วยนี้ได้ ก็ด้วยวิธีการสอนให้ AI ได้รู้จักการอ่านภาพซีทีสแกนจำนวนมหาศาล และให้เครื่องจักรรู้จักสังเกตส่วนประกอบที่แตกต่างระหว่างปอดที่มีเนื้อแปลกปลอม กับปอดที่สุขภาพปกติ

ความท้าทายที่ผ่านมาก็คือ คนไข้จำนวนหนึ่งอาจจะตรวจสุขภาพเป็นประจำทุกปี แต่ก็มีกรณีตัวอย่างที่คนไข้ตรวจร่างกายแล้วค่าทุกอย่างปกติ พอหนึ่งปีผ่านไปจึงตรวจพบว่าเป็นมะเร็ง ซึ่งปรากฏว่าเมื่อลองให้ AI ที่กำลังทดสอบ ลองกลับไปดูภาพซีทีสแกนที่เคยวินิจฉัยว่าปกติ แต่ AI กลับตรวจพบเนื้อร้าย ดังนั้น ลิลลีเพ็งเล่าว่า ตัวอย่างนี้จึงเป็นเหมือนพันธะสัญญาว่าจะต้องพัฒนาให้ AI สามารถเข้ามาช่วยหมอทำงานนี้เพื่อช่วยชีวิตคนให้ได้มากขึ้น

นี่จึงเป็นโจทย์ที่ลิลลี เพ็งให้ AI ลองสังเกตภาพซีทีสแกน ทั้งของคนไข้ที่ป่วยเป็นมะเร็ง รวมถึงเปรียบเทียบภาพในกรณีที่ตรวจแล้วปลอดภัยดีไม่เป็นมะเร็ง โดยใช้ภาพถ่ายที่มีความละเอียดสูงขนาด 10 gigapixel เพื่อส่องรายละเอียดและหาจุดสังเกตของเนื้อร้าย ที่บางครั้งมองเห็นได้เพียงแค่พิกัดเล็กๆ เหมือนดังเข็มที่ซ่อนอยู่ในกองฟาง ให้ AI จดจำแพทเทิร์นที่อาจนำไปสู่การเป็นมะเร็ง และเรียนรู้เพื่อนำมาวินิจฉัยผู้ป่วยในอนาคต

ซึ่งเวลานี้ จากการทดลอง AI สามารถช่วยคัดกรองมะเร็งปอดจากภาพซีทีสแกน โดยลดข้อผิดพลาดในการวินิจฉัยผิดว่าเป็นมะเร็ง (false positive) ได้ 11% และลดการวินิจฉัยผิดว่าไม่เป็นมะเร็ง (false negative) ได้ 5%

โปรเจ็กต์ก่อนหน้า เบาหวานขึ้นตา

ในแวดวงสุขภาพน่าจะยังสามารถใชั AI มาช่วยงานได้อีกมาก โดยเฉพาะอย่างยิ่งกับงานในส่วนที่มีข้อมูลและภาพจำนวนมหาศาล และมันยังตอบโจทย์ได้ดีในสถานการณ์ที่มีแพทย์เฉพาะทางไม่เพียงพอ เช่นภาวะขาดแคลนหมอที่อินเดีย

ลิลลี่ เพ็งกล่าวว่า ในอนาคต นอกจากจะคัดกรองมะเร็งจากภาพได้แล้ว ในมุมของหมอ ก็มองไปถึงระดับการปฏิบัติการที่ต้องทำงานแข่งกับเวลา โดยอยากให้ AI สามารถระบุได้ด้วยว่า มีเคสไหนบ้างที่ข้อมูลส่งสัญญาณผิดปกติจนมีความเร่งด่วนที่ต้องให้หมอกำชับคนไข้ให้ตรวจซ้ำทันที หรือกรณีใดที่ควรนัดกลับมาตรวจซ้ำภายในเวลาเท่าใด

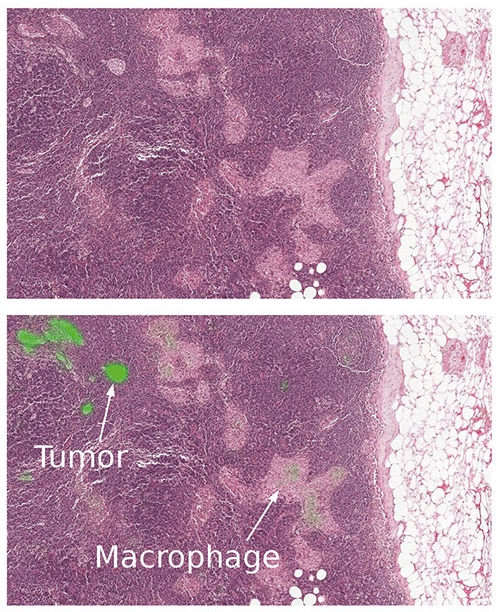

ภาพสแกนมะเร็งทรวงอก AI สามารถแยกแยะได้ว่า ส่วนใดเป็นเนื้องอก และส่วนใดเป็นถุงลม ภาพจาก https://ai.googleblog.com/2017/03/assisting-pathologists-in-detecting.html)

นอกจากการคัดกรองมะเร็งปอด (Lung Cancer Screening) ซึ่งกำลังพัฒนานั้น ลิลลี่ เพ็ง ยังมีงานวิจัยชิ้นอื่นที่ทำก่อนหน้านี้ ได้แก่ การใช้ AI ตรวจการแพร่กระจายของมะเร็งทรวงอก (Breast Cancer Nodal Metastasis)

ส่วนงานที่พัฒนาไปได้ไกลที่สุด ก็คือการใช้ AI คัดกรองภาวะเบาหวานขึ้นตา (Dianetic Retinopathy Screening) ซึ่งเป็นงานศึกษาอีกชิ้นที่ร่วมมือกับโรงพยาบาลในประเทศไทยและอินเดีย โดย AI สามารถคัดกรองผ่านการวิเคราะห์จากภาพเส้นเลือดฝอยที่หล่อเลี้ยงจอตาว่า มีภาวะอุดตันจากระดับน้ำตาลในเลือดสูง หรือไม่ เพราะหากไม่รู้ตัวแล้วปล่อยทิ้งเอาไว้นานก็จะทำให้ร่างกายสร้างเส้นเลือดใหม่ขึ้นมาแทน และอาจส่งปัญหาที่อาจทำให้ตาบอดได้

ประโยชน์ของ AI ในงานลักษณะนี้ นอกจากช่วยทำให้ผลการวินิจฉัยแม่นยำขึ้นแล้ว ยังช่วยแก้ปัญหาที่หลายพื้นที่ เช่น ในอินเดียที่กำลังขาดแคลนจักษุแพทย์ โดยยังต้องการหมอเฉพาะทางด้านตาอีกกว่า 127,000 คน นั่นทำให้มีคนไข้ราว 45% ที่ประสบปัญหาการมองเห็นก่อนที่จะมีโอกาสได้ตรวจรักษา

งานชิ้นดังกล่าวศึกษาเสร็จสิ้นแล้ว แต่อยู่ระหว่างขั้นตอนของการนำไปปฏิบัติให้ได้จริง (Validating Process) ซึ่งมีกระบวนการที่ต้องจัดการ เช่น การทำมั่นใจว่าภาพสแกนที่ถ่ายมานั้นเป็นภาพที่เครื่องชัดอ่านได้ มีความคมชัดสูงพอ และระบุได้ว่า กรณีใดบ้างที่จะต้องขอให้หมอบอกคนไข้ว่าจะต้องนัดมาตรวจซ้ำแล้วถ่ายภาพใหม่ กรณีการใช้งานในประเทศไทยนั้น ลิลลี่ เพ็งกล่าวว่า เวลานี้ยังอยู่ระหว่างรอการรับรองจากฝ่ายกำกับดูแลด้านสาธารณสุขของไทย เธอเสริมว่า ในทางการแพทย์ แม้ว่า AI จะได้รับการรับรองแล้ว แต่ยังมีอีกหลายปัจจัยเช่นกัน ที่จะทำให้สามารถนำเครื่องมือใหม่นี้มาใช้งานในสเกลใหญ่ได้อย่างมีประสิทธิภาพ

AI เพื่อสังคมเกิดขึ้นได้ เพราะมี TensorFlow

นอกจากการใช้ AI เพื่อสุขภาพแล้ว ในงาน Solve….with AI ของกูเกิล ยังมีตัวอย่างการพัฒนาเครื่องจักรให้ประยุกต์ใช้งานกับเรื่องสิ่งแวดล้อม สัตว์โลก การเกษตร และภัยพิบัติด้วย

เจฟฟ์ ดีน (Jeff Dean) หัวหน้าทีม Google AI

เจฟฟ์ คือหัวหน้าโปรเจ็กต์ของโครงการ AI ทั้งหมด เขาอธิบายพื้นฐานของงานนี้ว่า AI หรือ Artificial Intelligent ก็คือศาสตร์ของการทำให้สิ่งต่างๆ ฉลาดขึ้น ซึ่งเสริมด้วยการทำงานของ Machine Learning คือการสอนให้เครื่องจักรฉลาดกว่าเดิม

โดยกูเกิลยังเปิดให้นักพัฒนาสามารถใช้เครื่องมือ Machine Learning ของกูเกิลที่ชื่อว่า TensorFlow สิ่งที่สำคัญคือ กูเกิลเปิดให้นักพัฒนาทุกคนสามารถใช้งานได้เพราะเป็นโอเพ่นซอร์ส และยังเปิดรับพาร์ตเนอร์ที่สนใจสร้างนวัตกรรมเพื่อสังคม ที่ตอนนี้มีความร่วมมือจากนักพัฒนาที่เสนอโครงการเข้ามาทำร่วมกันกับกูเกิลอีกกว่า 100 โครงการ และนั่นจึงทำให้ไอเดียริเริ่มโครงการเจ๋งๆ ไม่ได้จำกัดอยู่แค่องค์กรใดองค์กรหนึ่ง แต่คนทั่วไปสามารถร่วมใช้ซอฟต์แวร์นี้ไปด้วยกัน

เวลานี้ มีการใช้ TensorFlow ไปพัฒนากับประเด็นต่างๆ ทั้งเรื่องใหญ่ๆ อย่าง การใช้ AI ช่วยเตือนเมื่อมีสัญญาณของการลักลอบตัดไม้ทำลายป่า หรือให้ AI ช่วยสังเกตและติดตามสัตว์ใกล้สูญพันธุ์ หรือประเด็นขนาดย่อยที่ใช้ในครัวเรือนอย่างการใช้ AI ช่วยแยกเกรดแตงกวาในฟาร์มแตงกวาที่ญี่ปุ่น

แล้วหมวดหมู่ต่างๆ ที่กูเกิลเลือกพัฒนา AI ให้ฉลาดไปในทางนั้นๆ นั้น กูเกิลเลือกจากอะไร หลายคนถาม ในวงการนักพัฒนามีข้อกังวลมาหลายปีแล้วว่า ถ้าถึงวันที่เครื่องจักรมันฉลาดมากจนเราอาจจะประเมินศักยภาพได้ไม่เท่าทันเราจะทำอย่างไร หรือควรจะป้องกันมันได้ไหม งานนี้เจฟฟ์เล่าว่า นอกจากการศึกษาให้เครื่องจักรฉลาดและมีประสิทธิภาพแล้ว กูเกิลก็ต้องทุ่มเทไปกับการศึกษาวิจัยเรื่องความรับผิดชอบทางสังคมด้วย

โดยตอนนี้ งานพัฒนาปัญญาประดิษฐ์ (AI) ต่างๆ ต้องอยู่ภายใต้กรอบ Google AI Principles ซึ่งเป็นหลักการการพัฒนาอย่างมีความรับผิดชอบ โดยในแนวทางที่ต้องมุ่งไปและแนวทางที่เป็นข้อห้าม คือ

AI ควรจะ

- เป็นประโยชน์ต่อสังคม (Be socially beneficial)

- หลีกเลี่ยงการผลิตหรือซ้ำเติมอคติที่ไม่เป็นธรรม (Avoid creating or reinforcing unfair bias)

- สร้างและทดสอบเพื่อความปลอดภัย (Be built and tested for safety)

- รับผิดชอบต่อเพื่อนมนุษย์ (Be accountable to people)

- ยึดหลักการการออกแบบที่คำนึงถึงเป็นส่วนตัวในการสร้างสรรค์งานต่างๆ (Incorporate privacy design principles)

- สนับสนุนและส่งเสริมมาตรฐานของงานวิทยาศาสตร์ที่เป็นเลิศ (Upholding high standards of scientific excellence)

- ทำให้เกิดการใช้งานได้ตามหลักการข้างต้น (Be made available for uses that accord with these principles)

สิ่งที่จะไม่ทำ

- มีแนวโน้มที่จะนำไปสู่อันตราย (Likely to cause overall harm)

- มีเป้าหมายที่จะสร้างความเสียหาย (Principle purpose to direct injury)

- สอดส่องโดยละเมิดมาตรฐานที่สากลให้การยอมรับ (Surviellance violating internationally accepted norms)

- ทำลายหลักกฎหมายระหว่างประเทศและหลักสิทธิมนุษยชน (Purpose contravenes international law and human rights)

ใช้ AI ช่วยเราและโลก กับโครงการปัญญาประดิษฐ์เพื่อสังคม

ในโครงการ AI for Social Good หรือการใช้ปัญญาประดิษฐ์เพื่อสังคม นอกจากการฝึก AI ให้ช่วยคัดกรองมะเร็งซึ่งเป็นส่วนหนึ่งของการใช้งาน AI เพื่อสุขภาพแล้ว ยังมีการพัฒนาการเรียนรู้ของเครื่องจักร ให้ช่วยแก้ไขปัญหาสังคมด้านอื่นๆ ทั้งเรื่องปัญหาสิ่งแวดล้อม ป่าและสัตว์ป่า และสร้างการเข้าถึงโอกาสต่างๆ ให้กลุ่มชายขอบหรือกลุ่มที่อยู่ในความเสี่ยงด้วย

และต่อไปนี้คือตัวอย่าง

1.ตามเสียงร้องเพลงของวาฬเพื่อปักเขตคุ้มครอง

วาฬร้องเพลงได้ มันร้องเพลงเพื่อสื่อสาร เพื่อหาคู่ เสียงร้องของมัน ดังไปได้ไกลนับร้อยไมล์ใต้ทะเล และด้วยเหตุนี้เองที่ทำให้นักอนุรักษ์พยายามศึกษาและบันทึกเสียงของวาฬ เผื่อจะช่วยดูแลและปกป้องมันได้

สาเหตุการตายส่วนใหญ่ของวาฬ เกิดจากการติดกับไปกับอุปกรณ์สำหรับจับปลา และการว่ายชนเรือยนต์ ดังนั้น โจทย์จึงเริ่มต้นที่ว่า ถ้ารู้ว่าวาฬอยู่ตรงไหน ก็สามารถระบุเขตคุ้มครองหรือแจ้งเตือนชาวประมงให้ระวังเครื่องยนต์ไปทำร้ายวาฬได้ แต่จะทำได้ก็ต้องรู้ก่อนว่ามันอยู่ตรงไหน แต่จะรู้ได้อย่างไรเพราะวาฬไม่ค่อยว่ายโผล่มาที่ผิวน้ำ จะมองหาด้วยสายตาจึงเป็นเรื่องยาก

NOAA ศูนย์วิจัยวิทยาศาสตร์การประมงแห่งหมู่เกาะแปซิฟิก ที่มีหน้าที่จับตาและคุ้มครองประชากรวาฬและสัตว์น้ำที่เลี้ยงลูกด้วยนมประเภทอื่นๆ จึงใช้วิธีบันทึกเสียงใต้น้ำ โดยนับแต่ปี 2005 NOAA วางเครื่องบันทึกเสียงความถี่สูงใต้น้ำที่ทะเลแปซิฟิกไว้ทั้งหมด 12 จุด มีฐานข้อมูลเสียงใต้น้ำกว่า 170,000 ชั่วโมง ซึ่งหากจะนั่งฟังไปเรื่อยๆ ก็คงใช้เวลานานถึง 19 ปี

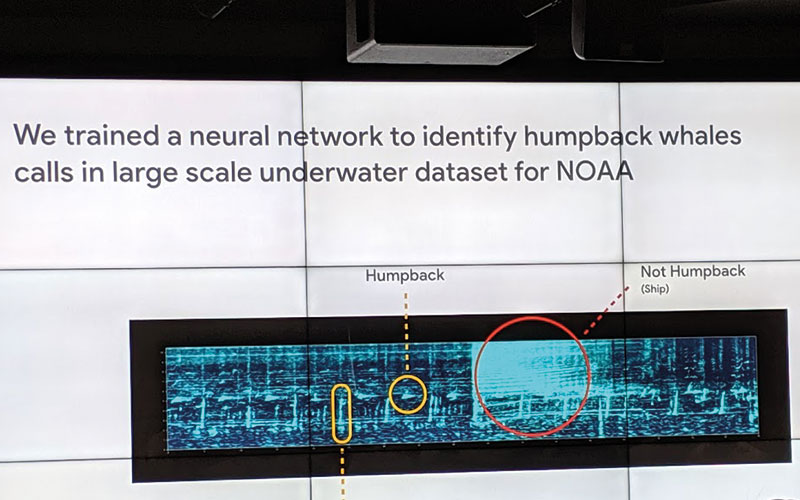

ด้วยโอกาสที่ NOAA เก็บบันทึกข้อมูลเสียงเอาไว้มหาศาล ทำให้ NOAA ร่วมกับกูเกิลพัฒนาโครงข่ายประสาทเทียม (Deep Neural Network) โดยเริ่มฝึกการแยกแยะเสียงวาฬหลังค่อม (Humpback whales)

ความท้าทายในการสอนเครื่องจักรให้รู้จักเสียงของวาฬหลังค่อมก็คือ ในทะเลมีเสียงรบกวนหลายสิ่ง ไม่ว่าจะเป็นเสียงฝน เสียงเรือ ซึ่งเสียงของวาฬหลังค่อมก็แยกยาก ต่างจากเสียงของวาฬสีน้ำเงินและวาฬฟิน ที่มีความจำเพาะกว่า แต่วาฬหลังค่อมร้องเพลงด้วยเสียงที่ซับซ้อนและมีระดับเสียงที่หลากหลาย แถมยังเปลี่ยนแปลงไปได้ตลอดเวลา

จูลี แคททีโอ (Julie Cattiau) ทีม Google AI อธิบายว่า นักพัฒนาใช้วิธีแปลงข้อมูลเสียงให้แสดงผลออกมาเป็นภาพ หรือที่เรียกว่าสเป็กโตรแกรม (spectrogram) แล้วสอนให้อัลกอริธึมรู้ว่าตัวอย่างของสเป็กโตรแกรมใดตรงกับเสียงของวาฬสายพันธุ์ใด เมื่อเพิ่มตัวอย่างเข้าไปมากๆ อัลกอริธึมจะค่อยๆ ระบุเสียงร้องต่างๆ ว่าเป็นสายพันธุ์ใดได้โดยอัตโนมัติ

ในเวลานี้ จึงทำให้สามารถระบุได้ว่า วาฬหลังค่อมอยู่ตรงไหนในช่วงเวลาใด ซึ่งทำให้สามารถต่อยอดไปสู่การศึกษาในอนาคตได้ ไม่ว่าจะเป็นการศึกษาเรื่องถิ่นที่อยู่และการย้ายถิ่นฐานของสายพันธุ์ต่างๆ แนวทางการร้องของวาฬที่เปลี่ยนไป ความแตกต่างของเสียงวาฬแต่ละประเภท และยังสามารถกำหนดเขตคุ้มครองสัตว์ได้ด้วย

2. AI ดักฟังเสียงพวกตัดไม้ทำลายป่า

ขนาดวาฬยังฟังเสียงได้ จะตามล่าหาพวกนักไม้ทำลายป่าก็ไม่น่าจะใช่เรื่องเกินความสามารถของ AI ด้วยทักษะที่คล้ายกัน AI สามารถเรียนรู้ที่จะฟังเสียงที่เข้าข่ายผิดปกติในป่าได้ เช่น เสียงเลื่อยไม้

โทเฟอร์ ไวต์ (Topher White) ซีอีโอและผู้ก่อตั้งองค์กร Rainforest Connection ขณะบรรยายในงาน Google AI

นี่เป็นอีกประโยชน์ที่ได้จากการไม่หวงลิขสิทธิ์ แต่เปิดซอฟต์แวร์ให้เป็นโอเพ่นซอร์ส ที่กูเกิลให้นักพัฒนาสามารถใช้งาน TensorFlow ระบบการเรียนรู้ของเครื่องจักรเพื่อนำมาพัฒนาประเด็นทางสังคม โดย โทเฟอร์ ไวต์ (Topher White) ซีอีโอและผู้ก่อตั้งองค์กร Rainforest Connection ใช้ประโยชน์ของ TensorFlow ในการพิทักษ์ป่า

Rainforest Connection คือกลุ่มของวิศวกรไอทีที่สนใจใช้เทคโนโลยีมาช่วยชุมชนต่างๆ ซึ่งเขามองว่ากลุ่มคนที่เหมาะสมที่สุดในการคุ้มครองป่า ก็คือชุมชนท้องถิ่นและชนเผ่าที่อาศัยอยู่กับป่ามารุ่นต่อรุ่น

ทีมของเขาสร้างระบบตรวจจับแบบเรียลไทม์และระบบเตือนภัยในเวลาที่มีกลุ่มตัดไม้ทำลายป่าเข้าไปในพื้นที่ โดยเขาสร้างเครื่องมือทำดัดแปลงมาจากสมาร์ตโฟน โดยใช้พลังงานจากแสงอาทิตย์ ซึ่งเข้าตั้งชื่อว่า การ์เดียน (Guardian) หรือผู้คุ้มครอง แล้วไปซ่อนเอาไว้ในต้นไม้หรือพื้นที่เสี่ยงภัย แล้วใช้วิธีดักฟังเสียง

เสียงที่ดักฟังมานั้นจะป้อนเข้าสู่ระบบคลาวด์ ซึ่งใช้ TensorFlow วิเคราะห์เสียง หากได้ยินเสียงเลื่อยไฟฟ้า รถบรรทุกลากซุง หรือเสียงผิดวิสัยอื่นๆ ก็จะสามารถแจ้งเตือนไปยังชุมชนที่ดูแลป่าได้ตลอด 24 ชั่วโมง

3. ให้ AI ช่วยฟังเสียง เครื่องมือช่วยคนประสบปัญหาการได้ยิน

การอยู่ในโลกที่มีข้อจำกัดทางการได้ยิน ทำให้โอกาสและประสบการณ์จำกัดลง บางคนอาจหูหนวกแต่กำเนิด บางคนอาจประสบปัญหาทางการฟังจากเหตุอื่น และบางครั้งด้วยวัยที่เพิ่มขึ้นก็อาจทำให้ประสาทหูเสื่อมถอยได้ แต่ไม่ใช่ทุกคนที่สามารถใช้ภาษามือทดแทน หรือแม้จะรู้ภาษามือ แต่โลกก็แคบลงไปโดยปริยายเพราะสื่อสารได้เพียงวงจำกัด วันนี้ปัญหาเหล่านี้คลายลงไปบ้างแล้ว เพราะมีเครื่องมือ ‘ถอดความสด’ กับโปรแกรม Live Transcribe และโปรแกรมตัดเสียงรบกวนอย่าง Sound Amplifier

เทคโนโลยีที่ใช้ คือระบบ speech recognition แบบที่สมัยนี้เราใช้งานแชทด้วยการพูดใส่ไมค์ในสมาร์ตโฟนให้ระบบพิมพ์ออกมาให้นั่นเอง แต่กว่าระบบจะฟังเสียงแล้วถอดความได้อย่างทุกวันนี้ ต้องผ่านการพัฒนาซอฟต์แวร์มาอย่างต่อเนื่อง ดิมิทรี คาเนฟสกี (Dimitry Kanevsky) คือนักวิจัยที่กูเกิล ผู้ซึ่งทำงานด้านนี้มา 30 ปี ตัวเขาเองเป็นคนหูหนวกตั้งแต่เด็ก ทักษะการฟังที่หายไปนี้เองช่วยผลักดันให้เขาสร้างเทคโนโลยีเพื่อการสื่อสาร โดยก่อนหน้านี้ เขาผลิตโปรแกรมที่ชื่อว่า CART ซึ่งเป็นระบบที่จะถอดเสียงจากการประชุมออกมาเป็นคำพูดบนจอโดยทันที แต่หากจะใช้ CART ก็มีเครื่องมือวุ่นวายที่ต้องเตรียมพร้อมมาเป็นอย่างดี นั่นหมายความว่า จะใช้ CART ได้ก็ต้องอยู่ในการประชุมที่พิเศษ ไม่ใช่ใช้งานในบทสนทนาประจำวัน

แต่ CART ก็เป็นโปรโตไทป์ที่พัฒนาต่อมาได้ ซึ่งถึงที่สุดแล้ว มันได้พัฒนามาเป็นแอปพลิเคชั่นที่ชื่อ Live Transcribe เพียงติดตั้งในสมาร์ตโฟน แอปนี้จะฟังเสียงสนทนาแล้วแสดงคำบรรยายออกมาโดยทันควัน

ซาการ์ ซาฟลา ทีม Google AI ที่ดูแลโครงการนี้บอกว่า ตอนนี้ Live Transcribe สามารถถอดเสียงสนทนาได้มากกว่า 70 ภาษาหลักและภาษาถิ่น โดยระบบอยู่ในขั้นทดลอง (beta) ในวงจำกัด โดยผู้ใช้สามารถติดตั้งโดยตั้งค่าเปิดในเมนูความสามารถในการเข้าถึง (Accessibility) ซึ่งใช้ได้แล้วกับสมาร์ตโฟนแอนดรอยด์

ซาการ์ ซาฟลา ทีม Google AI

ส่วนแอปพลิเคชั่น Sound Amplifier นั้น ช่วยขยายเสียงและเพิ่มประสิทธิภาพในการฟังให้กระจ่างมากขึ้น สามารถใช้งานทั้งกับคนที่มีปัญหาด้านการฟัง และกับกรณีที่อยู่ในสถานที่ที่เต็มไปด้วยเสียงรบกวน เพราะระบบจะขยายเสียงที่จำเป็นโดยไม่เพิ่มเสียงรบกวน ซึ่งผู้ใช้งานก็ฟังเสียงผ่านระบบนี้ผ่านการใส่เฮดโฟนที่ต่อกับสมาร์ตโฟนระบบแอนดรอยด์

4. โปรเจ็กต์ Euphonia ช่วยคนที่มีภาวะบกพร่องทางการพูดให้สื่อสารได้

ทุกวันนี้ ผู้คนนับล้านต้องต่อสู้กับอาการทางระบบประสาท ซึ่งร่างกายอาจได้รับผลกระทบจากอาการต่างๆ ไม่ว่าจะเป็นอาการสโตค, ALS, กล้ามเนื้ออ่อนแรง, สมองได้รับกระทบกระเทือนจากอุบ้ติเหตุ และโรคพาร์คินสัน อาการหนึ่งที่ตามมาคือ คนไข้จะไม่สามารถพูดได้ชัดถ้อยชัดคำดังที่เคย

โปรเจ็กต์ยูโฟเนียจึงเริ่มขึ้น เป็นงานอีกชิ้นที่ท้าทายและกำลังพัฒนา โดยทีมกูเกิลโฟกัสไปที่กลุ่มคนที่มีภาวะบกพร่องทางการพูด ทางกูเกิลได้รับความร่วมมือกับสถาบันอีก 2 แห่งที่ทำงานกับผู้ป่วยโรค ALS คือ ALS Therapy Development Institute (ALS TDI) และ ALS Residence Initiative (ALSRI)

จริงอยู่ว่า คนฟังที่ใกล้ชิดสนิทสนม อาจจะเข้าใจประโยคหรือคำง่ายๆ ของคนไข้ แต่สำหรับผู้พูดแล้ว การสื่อสารที่จะแสดงความรู้สึกซับซ้อนมันไม่เหมือนเดิมอีกต่อไป คนฟังก็ต้องใช้ความพยายามมากขึ้นซึ่งยิ่งทำให้ผู้พูดกังวลหรือเขินอาย

ทั้งสองสถาบันนี้จะช่วยบันทึกเสียงพูดของผู้เป็นโรค ALS แล้ว จากนั้น นักพัฒนาจะนำเสียงที่บันทึกมาเข้าระบบสเป็กโตแกรมที่แปลงเสียงให้ออกมาเป็นภาพของเส้นเสียง แล้วค่อยๆ สอนให้อัลกอริธึมของ AI ทำความเข้าใจแพทเทิร์นการพูดของผู้ป่วย ว่าการออกเสียงใดน่าจะหมายถึงคำคำใด

ตอนนี้งานชิ้นนี้ยังอยู่ระหว่างการพัฒนา โดยเริ่มต้นที่ผู้ป่วย ALS ที่ใช้ภาษาอังกฤษก่อน โดยหวังว่าจะสามารถขยายการเรียนรู้ไปสู่กลุ่มคนที่ใช้หลากหลายภาษาให้มากยิ่งขึ้น

ยิ่งไปกว่านั้น นอกจากการฟังเสียงพูดแล้ว นักพัฒนายังสอนให้ AI สังเกตท่าทางแล้วแปลงออกมาเป็นเสียง ทั้งนี้ เพื่อรองรับผู้ป่วยที่มีอาการสาหัสที่ทำให้ไม่สามารถพูดออกมาเป็นคำได้แล้ว โดยมีตัวอย่างกรณีของ สตีฟ แซลิง ซึ่งป่วยด้วยอาการ ALS มานานกว่า 13 ปี เขาสามารถใช้เสียงที่ไม่ใช่คำพูด (non-speech sounds) และการขยับท่าทางบนใบหน้า เพื่อส่งสัญญาณเสียงออกมาในการเชียร์กีฬาได้

จูลี แคททีโอ (Julie Cattiau) ทีม Google AI ผู้ดูแล ทั้งโครงการติดตามสัตว์ใกล้สูญพันธุ์ และโครงการ Euphonia

จูลี แคททีโอ (Julie Cattiau) ทีม Google AI ที่ดูแลโครงการนี้บอกว่า ด้วยความที่โครงการนี้ยังอยู่ขั้นต้นของการพัฒนา ทีมพัฒนาจึงยังต้องการตัวอย่างเสียงเพื่อนำมาสอนระบบให้มากเท่าที่ได้ โดยปัจจุบัน กำลังเปิดรับตัวอย่างเสียงพูด ซึ่งสามารถเข้าร่วมได้ผ่านแบบฟอร์มนี้ : https://docs.google.com/forms/d/e/1FAIpQLSeu8eBOUwzs7PdH25v4lTXjzOVO8rfmfNIoUovLForMmYRipA/viewform

Tags: เอไอ, TensorFlow, Google, กูเกิล